For selvom du holder dig til Long Term Support (LTS) -udgivelser, er Linux-distributioner ofte grundlæggende mere udsatte end Windows-maskiner for pludselig og spektakulært at gå ud af drift.

Hvorfor er det i så mange tilfælde sådan??

- Hardwarekompatibilitet, inklusive væsentlige komponenter som GPU'er, er fortsat en væsentlig udfordring, da mange leverandører stadig ikke understøtter Linux-distributioner, hvilket overlader det til samfundet at oprette løsninger;

- Open source's økonomiske model tilskynder ikke, langt mindre kræver grundige QA-processer;

- Og for dem der holder øje med frigivelser fra blødende kanter, har grundlæggende ændringer i pakkehåndteringsværktøjer en ubehagelig vane til undertiden at mure systemet ved at åbne en uoprettelig Pandoras kasse med afhængighedsfejl. Reparation af disse, selv når det er muligt, kan involvere udførelse af dage lange kaninhuller. Hvad der kan virke som en god læringsoplevelse for en førstegangsbruger, kan blive en frustrerende frustration for en veteranbruger på randen af at hoppe skib til Windows.

Og Linuxs stabilitetsproblem har rasende mange brugere. Gennemse mange bruger-i-nød tråde på AskUbuntu.com, og du støder på masser af frustrerede plakater, der har prøvet alt og i sidste ende har besluttet, at den eneste vej fremad er at installere fra bunden.

Mens dette gøres, kan det oprindeligt være en slags læringsproces, der opfordrer brugerne til med jævne mellemrum at overveje, hvordan de kan gøre deres system slankere og strømline gendannelsesprocessen, efter et stykke tid bliver det intet bedre end en stor, tidskrævende gener. Før eller senere begynder selv de mest avancerede strømbrugere at kræve stabilitet.

Jeg har brugt Linux som mit daglige operativsystem i mere end 10 år og har gennemgået min rimelige andel af uønskede rene installationer. Så mange faktisk, at jeg lovede, at min sidste geninstallation ville være min sidste. Siden da har jeg udviklet følgende metode. Og det har fungeret for at holde mit Lubuntu-system kørende så godt som den dag, jeg installerede det uden en geninstallation siden. Her er hvad jeg gør.

Overvejelser: Hvad skal du tage backup af?

Før du beslutter dig for en backup-strategi, skal du finde ud af nogle grundlæggende:

- Hvad har du brug for at tage backup af? Har du brug for at tage backup af den fulde partition / volumen eller bare hjemmebrugermappen?

- Er en inkrementel backupstrategi tilstrækkelig til din brugssag? Eller har du brug for at tage fulde sikkerhedskopier?

- Skal sikkerhedskopien krypteres?

- Hvor let har du brug for gendannelsesprocessen?

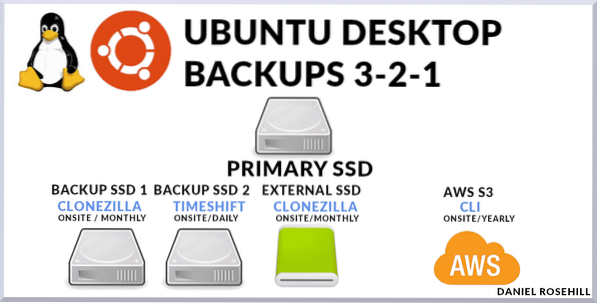

Mit backup-system er baseret på en blanding af metoder.

Jeg bruger Timeshift som mit primære backup-system, der tager trinvise snapshots. Og jeg gemmer en fuld disksikkerhedskopi på stedet, der udelukker mapper, der ikke indeholder brugerdata. I forhold til systemets rod er disse:

- / dev

- / proc

- / sys

- / tmp

- /løb

- / mnt

- /medier

- / mistet + fundet

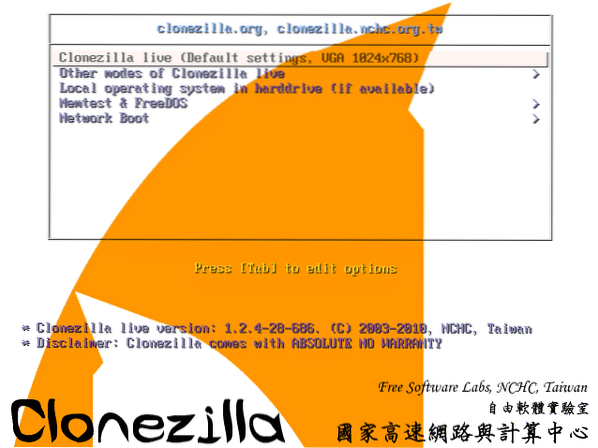

Endelig gemmer jeg yderligere to sikkerhedskopier. En af disse er en (ægte) fuld systempartition til billedbackup ved hjælp af en Clonezilla live USB. Clonezilla pakker en række værktøjer på lavt niveau til replikering af installationer. Og det andet er en offsite fuld system backup, som jeg uploader til AWS S3 ca. en gang om året, når jeg har en stor data uplink til min rådighed.

Indstillinger for sikkerhedskopieringsværktøjer

Disse dage er udvalget af værktøjer, du kan bruge, stort.

Det omfatter:

- Kendte CLI'er som rsync, der kan scriptes og kaldes som cron-job manuelt

- Programmer som Déjà Dup, Duplicity, Bacula, der giver GUI'er til at oprette og automatisere backup-planer til lokale eller off-site destinationsservere, inklusive dem, der drives af almindelige cloud-udbydere

- Og værktøjer, der grænseflade med betalte skytjenester som CrashPlan, SpiderOak One og CloudBerry. Den sidste kategori inkluderer tjenester, der selv giver billig cloud-lagerplads, så udbuddet er helt ende til slut.

3-2-1-reglen

Jeg vil give et hurtigt overblik over de værktøjer, jeg bruger i øjeblikket på min hovedmaskine.

Selvom jeg har skrevet nogle Bash-scripts for at få vigtige konfigurationsfiler til min primære skylager, som jeg bruger til daglige filer, bakker denne (den væsentlige) komponent i min backupplan simpelthen sikkerhedskopi af hele maskinen inklusive virtuelle maskiner og system filer, der skal udelades eller sikkerhedskopieres separat i mere nuancerede tilgange.

Dets centrale forudsætning er overholdelse af 3-2-1 backup-reglen. Denne tilgang skal holde dine data - inklusive dit primære operativsystem - sikre i næsten ethvert fejlscenarie.

Reglen siger, at du skal holde:

- 3 kopier af dine data. Jeg siger altid, at dette er lidt misvisende, fordi det faktisk betyder, at du skal beholde din primære datakilde og to sikkerhedskopier. Jeg vil blot henvise til dette som "to sikkerhedskopier"

- Disse to sikkerhedskopier skal opbevares på forskellige lagringsmedier. Lad os bringe dette tilbage til enkle vilkår for hjemmecomputering. Du kan skrive et simpelt rsync-script, der (trinvist) kopierer din vigtigste SSD til et andet tilsluttet lagringsmedie - lad os sige, at en HDD er knyttet til den næste SATA-port på dit bundkort. Men hvad sker der, hvis din computer tager fyr eller dit hus bliver røvet? Du vil blive efterladt uden din primære datakilde og har ingen sikkerhedskopi. I stedet kan du sikkerhedskopiere din primære disk til en NAS (Network Attached Storage) eller blot bruge Clonezilla til at skrive den til en ekstern harddisk.

- En af de to sikkerhedskopier skal gemmes uden for webstedet. Sikkerhedskopiering uden for stedet er vigtig, fordi hele dit hus kan blive ødelagt i tilfælde af en katastrofal naturlig begivenhed som f.eks. Oversvømmelse. Mindre dramatisk kunne en større overspændingshændelse stege al tilsluttet elektronik i et hus eller alle dem på et bestemt kredsløb (det er derfor, det er fornuftigt at holde en af sikkerhedskopierne på stedet uden forbindelse til en strømforsyning - et eksempel ville være en simpel ekstern harddisk / SDD ).Teknisk set er "offsite" hvor som helst, der er et fjerntliggende sted. Så du kan bruge Clonezilla til at skrive et billede af dit operativsystem eksternt til din arbejds-pc eller et drev, der er knyttet til det, over internettet. I disse dage er skylagring billig nok til at montere selv billeder med fuld drev billigt. Af den grund sikkerhedskopierer jeg mit system en gang om året til en Amazon S3-spand. Brug af AWS giver dig også massiv ekstra redundans.

Min backupimplementering

Min tilgang til sikkerhedskopier er baseret på et par enkle politikker:

- Jeg vil holde tingene så enkle som muligt;

- Jeg vil give mig selv den mest overflødighed, som jeg med rimelighed kan opnå;

- Jeg vil i det mindste følge 3-2-1 reglen

Så jeg gør som følger.

- Jeg har et ekstra drev på mit skrivebord, der udelukkende bruges til at huse Timehift gendannelsespunkter. Fordi jeg dedikerer en hel disk til den, har jeg ret meget plads til at lege med. Jeg holder en daglig, en månedlig og en ugentlig backup. Indtil videre er Timeshift alt, hvad jeg har brug for for at rulle systemet tilbage et par dage til et punkt, før noget, som en ny pakke, havde en negativ indvirkning på andre dele af systemet. Selvom du ikke kan komme forbi GRUB, kan Timeshift bruges som en CLI med rodrettigheder til at reparere systemet. Det er et utroligt alsidigt og nyttigt værktøj. Dette er en første kopi på stedet.

- Jeg har et ekstra drev på mit skrivebord, der udelukkende bruges til at huse Clonezilla-billeder af mit hoveddrev. Fordi disse billeder kun virkelig ville være nyttige for mig, hvis Timeshift mislykkedes, tager jeg kun disse en gang hver tredje til seks måneder. Dette er en anden kopi på stedet.

- Ved hjælp af Clonezilla opretter jeg en ekstra harddisk, som jeg holder hjemme eksternt til pc'en. Bortset fra at jeg på denne harddisk bruger en enhedsenhedskopiering i stedet for en enhedsbillede-sikkerhedskopi som i det foregående billede - så det ville være godt at gå øjeblikkeligt, hvis mit primære drev var muret. Hvis jeg f.eks. Skulle komme mig fra det interne Clonezilla-backupdrev, skulle jeg først følge en gendannelsesproces. Forudsat at de andre systemkomponenter er i god stand efter en harddiskfejl, behøver jeg teoretisk kun at forbinde dette drev til bundkortet for at begynde at bruge det. Dette er en tredje kopi på stedet.

- Endelig uploader jeg et Clonezilla-genereret billede af mit system en gang hver sjette måned til AWS S3. Det er overflødigt at sige, dette er en lang multipart-upload og skal foretages fra en internetforbindelse med et godt uploadlink.

Alt i alt involverer mit system tre on-site kopier og en off-site kopi af mit hoved Desktop.

Vigtigste takeaways

- Alle Linux-brugere skal have robuste backup-strategier på plads

- 3-2-1 backup-reglen er en god målestok for at sikre, at dine data er sikre under stort set alle omstændigheder.

- Jeg bruger en kombination af Timeshift og Cloudzilla til at oprette mine sikkerhedskopier, selvom der er masser af andre muligheder, inklusive betalte, på markedet. Til cloud storage bruger jeg en simpel AWS S3-skovl, selvom der igen er integrerede tjenester, der inkluderer både software og lagerværktøjer.

Phenquestions

Phenquestions